Physical Address

304 North Cardinal St.

Dorchester Center, MA 02124

Physical Address

304 North Cardinal St.

Dorchester Center, MA 02124

介绍文本向量化(词嵌入)技术:可视化 AI 如何用数字向量表示文本含义,计算语义相似度,以改进搜索和内容匹配的准确性。

随着 AI 应用在企业中的广泛落地,从智能客服到文档分析,从数据挖掘到知识管理,我们发现这些应用背后都依赖一些共同的核心技术,使机器能够更好地”处理”人类语言并”推断”其中的语义关联。今天,我们将深入探讨其中一项关键技术:向量化(Vectorization),特别是文本嵌入(Text Embedding)。

这项技术是众多现代 AI 功能的基石,包括智能搜索引擎、个性化推荐系统、简历与岗位的精准匹配,以及我们此前提到的 RAG 技术。

了解了向量化,你就能明白 AI 是如何超越简单的关键词匹配,通过统计学习和分布式表示,在一定程度上把握文本的深层关联。

想象一下,你需要在公司的海量文档库中查找关于“弹性工作制”的规定。

向量化技术正是为解决这个问题而生。它不仅关注文本表面的词语,更着眼于文本所表达的深层语义信息。

简单来说,向量化 Embedding 是将文本(词语、句子、段落)转换成一串数字组成的”向量”的过程。

你可以这样理解:我们使用经过特殊训练的 AI 模型(这些模型通过学习海量数据训练而成)为每个词语或文本片段在一个高维的数学空间(常被称为“语义空间”)中分配一个精确的”坐标”。这个”坐标”就是由一长串数字构成的向量。这个过程有两个关键特点:

这些概念听起来可能较为抽象,让我们通过几个具体的案例来直观感受一下。

这是一个经典的例子,展示了词向量如何捕捉词语之间的内在联系。

为了进行这个演示,我们使用了像网易有道这样的公司训练好的现成模型(例如 bce-embedding-base_v1)来获取”国王”、”男人”、”女人”、”女王”这四个词语的向量。模型会为每个词语生成一个向量,即一长串数字。

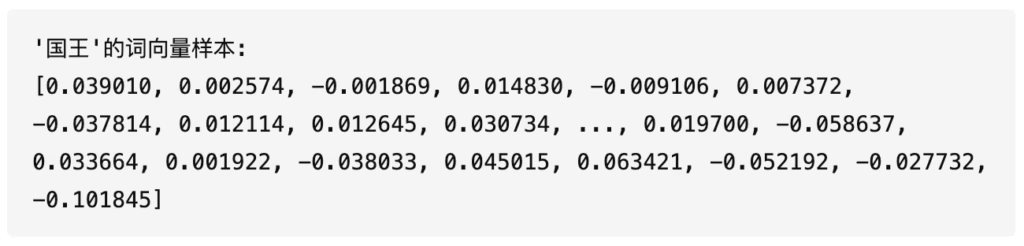

以”国王”为例,它的向量可能包含上千个数字,这里仅展示开头和结尾的10个数字:

由于向量通常包含几百甚至上千个数字,直接查看数字列表并不直观。我们可以使用热力图来可视化:将每个数字用一个色块表示,数值越大颜色越深,数值越小颜色越浅。这样,一长串数字就转化为一行彩色条带,更便于观察模式。下面是”国王”这个词的向量热力图示例:

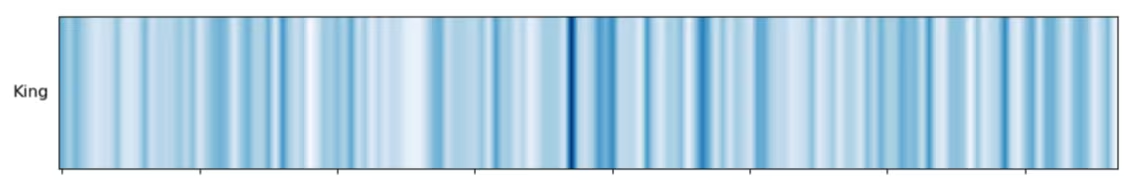

了解了向量的可视化方法后,让我们进行一个有趣的计算:用”国王”的向量减去”男人”的向量,再加上”女人”的向量。这个操作相当于在向量层面模拟:从”国王”所代表的语义中移除与”男性”相关的特征,再添加与”女性”相关的特征。

理论上,这个计算结果的向量应该在语义上非常接近”女王”的向量。为了验证这一点,我们将计算结果向量和”女王”的向量用热力图表示出来,并排放在一起比较。

观察热力图中最后两行(即”国王-男人+女人”的计算结果和”女王”),我们可以直观地看到它们的模式(颜色分布)高度相似。这种视觉上的一致性证明,向量运算确实捕捉到了预期的语义变化——它表明 Embedding 向量在其数值结构中编码了性别、地位等复杂的语义关系。

除了能捕捉词语间的关系,Embedding 向量还有一个有趣的特性:它们会自然地将意思相近的概念在”语义空间”中聚集在一起。让我们换个角度来观察这一点。

我们选取了三个不同类别的词语作为示例:水果类(如”苹果”、”香蕉”),动物类(如”猫”、”狗”),以及建筑类(如”摩天大楼”、”寺庙”),并获取它们的 Embedding 向量。

这些向量维度很高,难以直观展示。为此,我们使用了一种数学降维方法(如 t-SNE 或 PCA,可以理解为一种“压缩”或“投影”技术),在降低维度的同时尽量保持向量之间的相对距离关系。这样,每个词语的向量就能在二维或三维空间中用一个点来表示。

从图中可以清晰地看到明显的聚类现象:水果类词语自然聚在一起,动物类词语形成另一个群组,建筑类词语也各自成群。不同类别之间界限分明。这种基于语义的自然分组展示了 Embedding 的核心特征,让计算机能够量化和识别概念间的相似性,为语义搜索、信息分类和内容推荐等应用打下基础。

现在,让我们看看向量化技术在实际应用中如何发挥作用,特别是在智能信息检索领域。这项技术为企业知识库问答、法规文档查询、简历库人才搜索,以及相似历史项目案例匹配等提供了关键支持。以人力资源规章制度查询为例,让我们来拆解这个过程:

首先是处理信息源。在 HR 场景中,这指的是公司的各项规章制度文档。系统会预先读取这些文档,并将每条规章(或根据需要将文档拆分成更小的段落)作为独立的文本单元。

接着,系统调用 Embedding 模型,将这些文本片段转换成各自的向量。这些包含文本语义信息的向量与其对应的原文一起存入专门的“向量数据库”或“向量索引库”,为后续快速查找做准备。

当用户提出问题,如”我有多少天年假?”(或在其他场景下输入一份新简历、一个待匹配的案例描述等),系统会执行以下关键步骤:

查询向量化: 使用与处理知识库时完全相同的 Embedding 模型,将用户输入转换成一个查询向量。这确保了查询向量和文档向量处于同一个”语义空间”中,使得它们的比较具有实际意义。

有了用户查询向量和知识库中所有规章制度的向量后,关键问题是:如何判断哪些内容在意思上最接近用户的查询?

还记得案例二中,意思相近的词语(如各类水果)在降维后的空间中会自然聚集,它们的点距离很近吗?

这里运用的正是相同的原理!计算机需要计算出用户查询向量与知识库中每个文档向量之间的”语义相似度“。

为了更直观地理解这个基于方向的相似性概念,我们可以看下面这个简化的三维空间示意图:

系统使用余弦相似度,计算用户查询向量与向量库中每个规章制度向量的相似度得分。

系统根据相似度得分,对所有规章制度从高到低排序。得分最高的条目(即在”语义空间”中与查询向量最”接近”的文档)会作为最相关的结果呈现给用户。

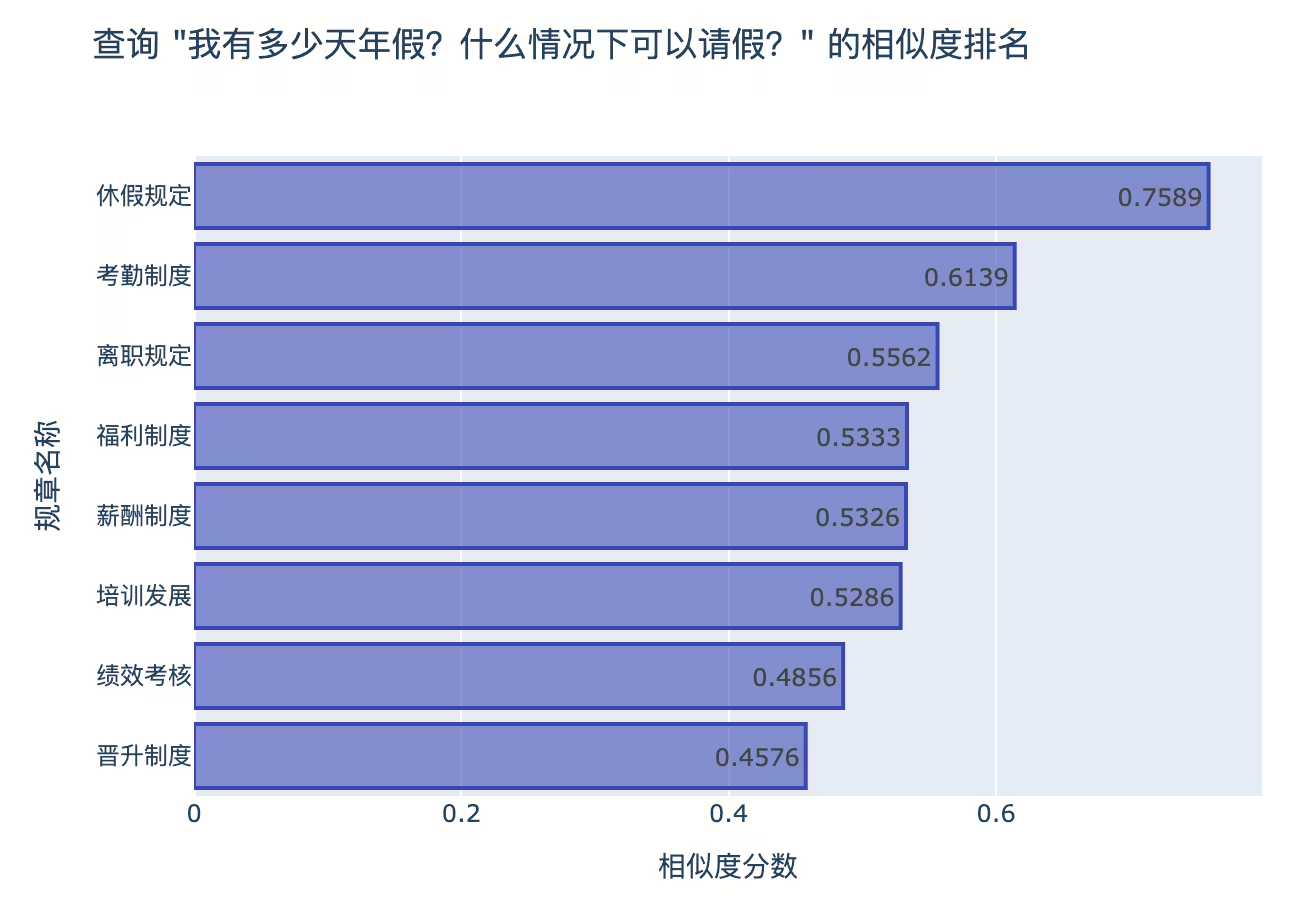

下面的条形图展示了排序结果。当用户查询”我有多少天年假?什么情况下可以请假?”时,系统计算出的各规章制度与查询的余弦相似度得分如下:

通过衡量向量间的语义相似度,系统准确识别出”休假规定”和”考勤制度”这两份文档与用户查询语义最接近,因此将它们排在最前。这种基于语义相似度计算而非简单关键词匹配的方式,是现代AI应用(如智能问答、简历筛选、案例推荐、内容发现等)能提供更智能、更准确服务的核心机制,标志着相比传统搜索方法的重大进步。

向量化 Embedding 作为一项核心 AI 技术,其本质是将文本转化为蕴含丰富语义信息的数字向量。这种转换使得机器能够摆脱对字面关键词的严格依赖,转而通过计算向量间的相似度(如余弦相似度),从而捕捉文本的语义信息与内在关联。

从我们的案例可以看到,Embedding 在多个方面都发挥着重要作用:它能揭示词语间的复杂关系(如性别、地位)、实现概念的自动聚类,更能驱动 RAG 等应用进行高效的语义检索。它赋予了机器处理语义相似性、进而在一定程度上捕捉’言外之意’的能力,推动 AI 应用从简单的’字符匹配’迈向更深层的’语义匹配与内容关联‘。

需要强调的是,向量化 Embedding 是 AI 处理语言的一种强大工具和重要技术,尤其擅长处理语义相似度和关联性任务,但它并不等同于 AI 具备了人类那样全面、灵活、带推理能力的语言”理解”。像大型语言模型(LLMs)等更复杂的 AI 系统,其内部处理语言的方式远比单纯的 Embedding 向量运算要复杂得多,涉及到注意力机制、Transformer 架构等多重技术的协同作用。

然而,深入理解 Embedding 的原理,能帮助我们更准确地认识当前 AI 技术栈中一个重要组件的能力与应用场景,从而更有效地运用这些工具解决实际问题。

希望本文帮助你理解了这个既有趣又实用的向量化技术。如果你对 AI 在人力资源或其他领域的应用有任何想法或疑问,欢迎留言交流!